CSUR 25 | 赋能边缘智能:设备端AI模型的综合综述

分享我们近日被ACM Computing Surveys录用的文章“Empowering Edge Intelligence: A Comprehensive Survey on On-Device AI Models”,该论文主要对设备端边缘智能方向的工作进行了综述。论文的通讯作者为IEEE Fellow贾维嘉教授,合作者包括北京师范大学的王田教授、郭剑雄副教授、王晨豪副教授、唐志清博士以及北师港浸大的孟天晖博士。

引用信息: Xubin Wang, Zhiqing Tang, Jianxiong Guo, Tianhui Meng, Chenhao Wang, Tian Wang, Weijia Jia, *Empowering Edge Intelligence: A Comprehensive Survey on On-Device AI Models, ACM Computing Surveys, Mar 2025.

论文链接:https://arxiv.org/pdf/2503.06027

期刊简介

《ACM Computing Surveys》自1969年创刊以来,受到全球顶尖学者的广泛关注和一致认可。该期刊致力于接收计算机领域具有代表性的前沿综述论文,是计算机领域的国际顶级期刊,属于中科院SCI一区Top,最新影响因子达到28.0,目前在Cite Score上排名第一。

研究成果概述

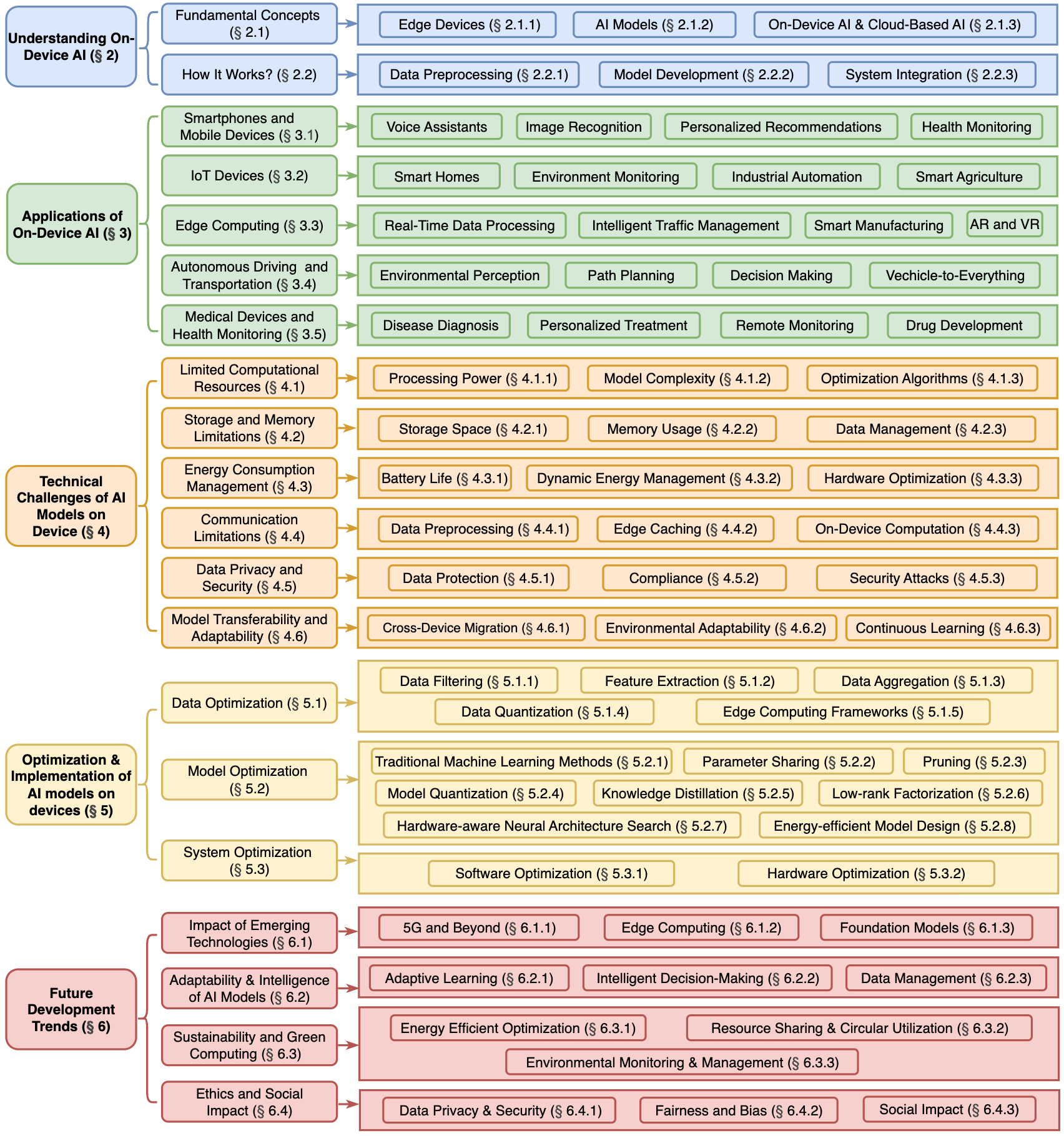

本综述深入探讨了设备端人工智能模型的基本概念、应用场景及其面临的技术挑战。首先,论文定义了设备端AI模型的特征,包括实时性能、资源限制和数据隐私保护,并分析了其在智能手机、智能家居、自动驾驶和医疗设备等领域的应用。接着,综述详细讨论了设备端AI模型所面临的主要挑战,如计算资源的限制、能量管理和数据隐私问题。为应对这些挑战,研究者们提出了多种优化和实施策略,包括模型压缩、数据预处理和系统集成等。此外,综述还探讨了边缘计算和基础模型等新兴技术对设备端AI模型演变的影响,强调了这些技术在推动智能系统发展中的重要性。

1. 综述介绍

1.1 背景信息

近年来,人工智能(AI)技术取得了飞速发展,其应用已渗透到各行各业。随着物联网(IoT)设备的普及和对实时数据处理需求的日益增长,将AI模型部署在边缘和终端设备上的趋势愈发明显。这种转变旨在实现本地数据处理和推理,从而满足实时性能、资源约束和增强数据隐私等关键需求。

从AlphaGo到ChatGPT等突破性进展展示了AI在不同领域的巨大潜力。然而,尽管成就斐然,由于高计算需求、可扩展性和隐私问题等因素,在现实世界中部署AI应用仍然面临诸多挑战。例如,像GPT-3这样拥有数千亿参数的大型语言模型虽然能力强大,但其庞大的规模对设备端部署构成了显著的限制。

1.2 综述目的

本文旨在对设备端AI模型的当前状态、技术挑战和未来趋势进行全面的探索和概述。我们明确本综述的目的在于提供一个结构化的视角,阐明设备端AI模型的基本概念、应用场景、所面临的技术难题以及相应的优化和实现策略。

通过对相关文献的回顾和分析,本综述期望能够为研究人员和工程师提供清晰的思路,帮助他们理解与设备端AI模型相关的关键问题和解决方案。此外,本文还将探讨新兴技术(如边缘计算和基础模型)对设备端AI模型发展的影响,从而促进该领域的进一步研究和应用,最终推动日常生活中智能系统的进步。

2. 研究主题概述

2.1 主题定义

设备端AI模型是指那些被设计、训练和部署在边缘或终端设备上的AI模型。这些模型能够在本地执行数据处理和推理,而无需将数据传输到云端进行处理。设备端AI模型通常具备以下关键特征:

- 实时性能:能够快速响应用户请求,适用于需要即时反馈的应用。

- 资源约束:在计算能力、存储空间和能源消耗方面受限,需要进行优化以适应设备的硬件环境。

- 数据隐私:通过本地处理数据,降低数据传输风险,从而增强用户隐私保护。

2.2 研究范围

本综述涵盖了设备端AI模型领域的核心概念、应用场景、技术挑战、优化与实现策略以及未来发展趋势。具体而言,研究范围包括:

- AI模型的基本概念,以及与云端AI模型的比较。

- 设备端AI模型在智能手机、物联网(IoT)设备和边缘计算等各个领域的应用场景。

- 部署设备端AI模型所面临的主要技术挑战,如计算资源、存储、能源、通信带宽、数据隐私安全以及模型的可迁移性和适应性限制。

- 提升设备端AI模型性能的有效优化和实现方法,包括数据优化、模型压缩和硬件加速技术。

- 新兴技术(包括边缘计算和基础模型)对设备端AI模型演进的影响。

本综述旨在提供对这些关键主题的结构化概述,并分析相关的挑战、解决方案和未来方向。

3. 文献回顾

3.1 主要研究成果

过去的研究在设备端AI的各个方面做出了重要贡献。例如,Shi等人和Dai等人的综述侧重于边缘系统中高效的通信和计算卸载,这对于优化设备端AI模型的性能至关重要。Zhang等人则探讨了移动边缘AI在车联网中的应用,而Park等人概述了支持设备端AI功能的无线网络智能。近年来,Deng等人强调了AI在边缘设备上的双重角色以及对边缘功能的支持,主要关注将模型部署到更靠近数据源的基础设施需求(Xu等人;Murshed等人)。此外,Xu等人还专门针对设备端语言模型进行了综述,而Dhar等人则从算法和学习理论的角度全面概述了设备端机器学习(ML)。

3.2 研究方法

本综述通过回顾和分析相关的学术文献,对设备端AI模型的当前状态、技术挑战和未来发展趋势进行了全面的考察。我们系统地梳理了近年来在该领域发表的重要研究成果,并对不同研究提出的概念、方法和结论进行了归纳和比较。

3.3 理解框架

尽管之前的研究为设备端AI奠定了重要的基础,但很少有研究能够提供一个针对边缘环境约束而专门设计的、高效设备端AI模型部署的综合视角。本综述旨在填补这一空白,不仅总结了设备端AI的进展,还深入探讨了数据、模型和系统设计这三个方面的优化策略,从而构建一个更全面的理解框架。

4. 研究现状与趋势

4.1 当前状态

随着物联网、边缘计算和移动设备的普及,越来越多的AI模型被部署在设备端。这种转变不仅提高了数据处理的实时性和效率,还减少了对网络带宽的依赖并加强了数据隐私保护。根据Gartner的预测,到2025年,大约75%的企业生成数据将在传统数据中心之外产生。在集中式云系统中传输和处理这些数据会带来显著的系统和延迟开销,以及巨大的带宽需求。

边缘智能通过将AI算法直接部署在边缘设备上来增强本地化数据处理的概念,从而减少对云基础设施的依赖。这种方法不仅加快了数据处理速度,还解决了重要的隐私和安全问题,因为敏感数据保留在本地环境中。设备端AI模型已广泛应用于智能手机、智能家居系统、自动驾驶汽车和医疗设备等各种场景。然而,在边缘设备上有效实施AI模型仍然面临着严峻的挑战。这些模型对大量参数和强大处理能力的需求,促使人们开发创新的模型压缩、优化和适应特定操作环境的策略。

4.2 研究趋势

当前的研究趋势主要集中在设计计算高效且能适应边缘环境的AI模型。这些进展将促进AI在工业4.0等领域的更广泛应用,在这些领域,实时、自动化的数据处理对于监控、风险检测和优化工厂运营至关重要。为了应对设备端AI模型的资源限制,研究人员正在积极探索各种优化技术,例如:

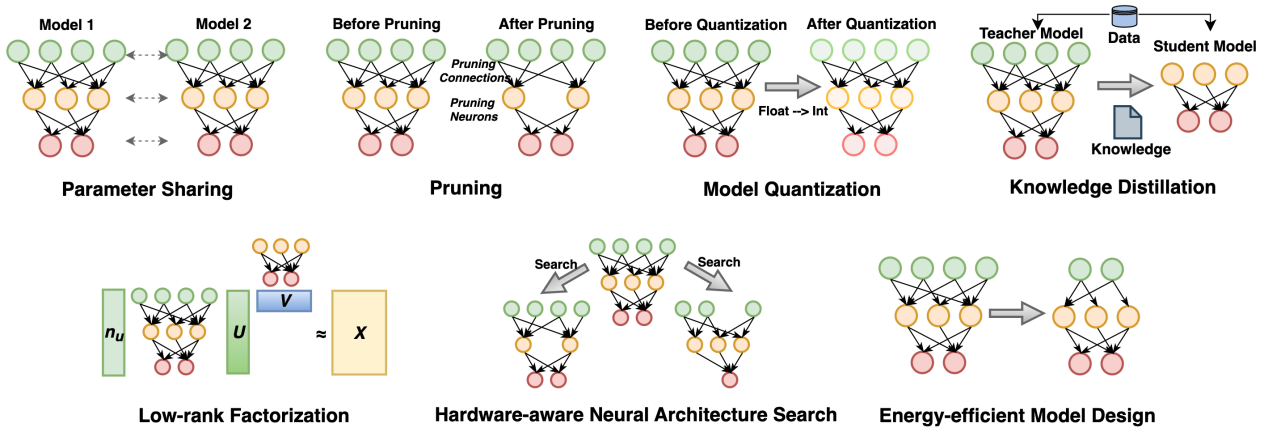

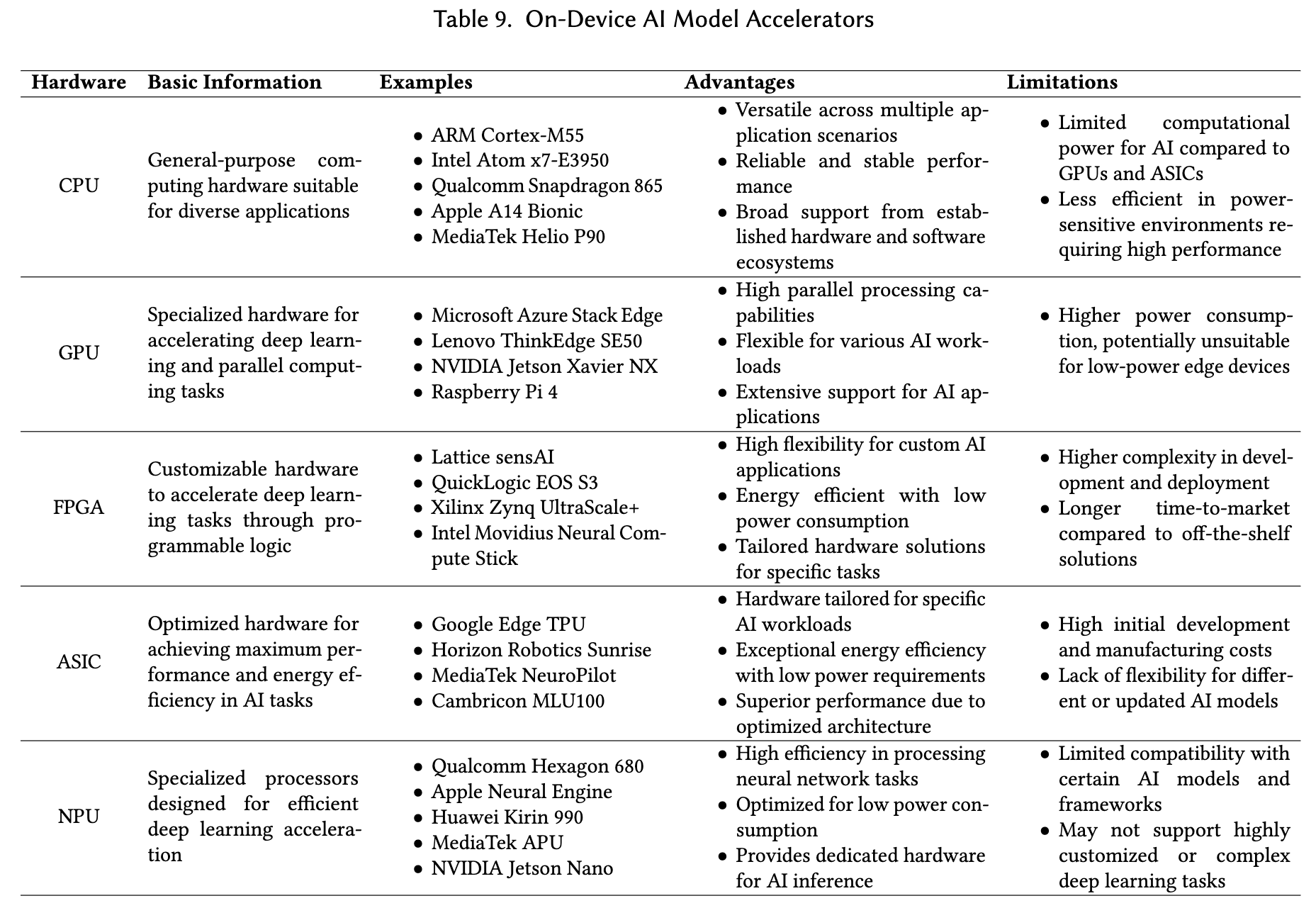

- 模型压缩:包括剪枝、量化和知识蒸馏等方法,以减少模型的大小和计算需求。

- 高效的网络架构设计:如MobileNets、ShuffleNets等,旨在提高模型在资源受限设备上的运行效率。

- 硬件加速:利用专用硬件(如FPGA、TPU)来提升计算性能。

此外,联邦学习等隐私保护的分布式学习方法也受到越来越多的关注。未来,随着5G、边缘计算和基础模型等新兴技术的不断发展,设备端AI模型的性能和应用范围将得到进一步的拓展。模型的可解释性、公平性和可持续性也将成为重要的研究方向。

本综述从数据、模型和系统三个方面详细介绍了在设备上优化和实施人工智能模型的方法:

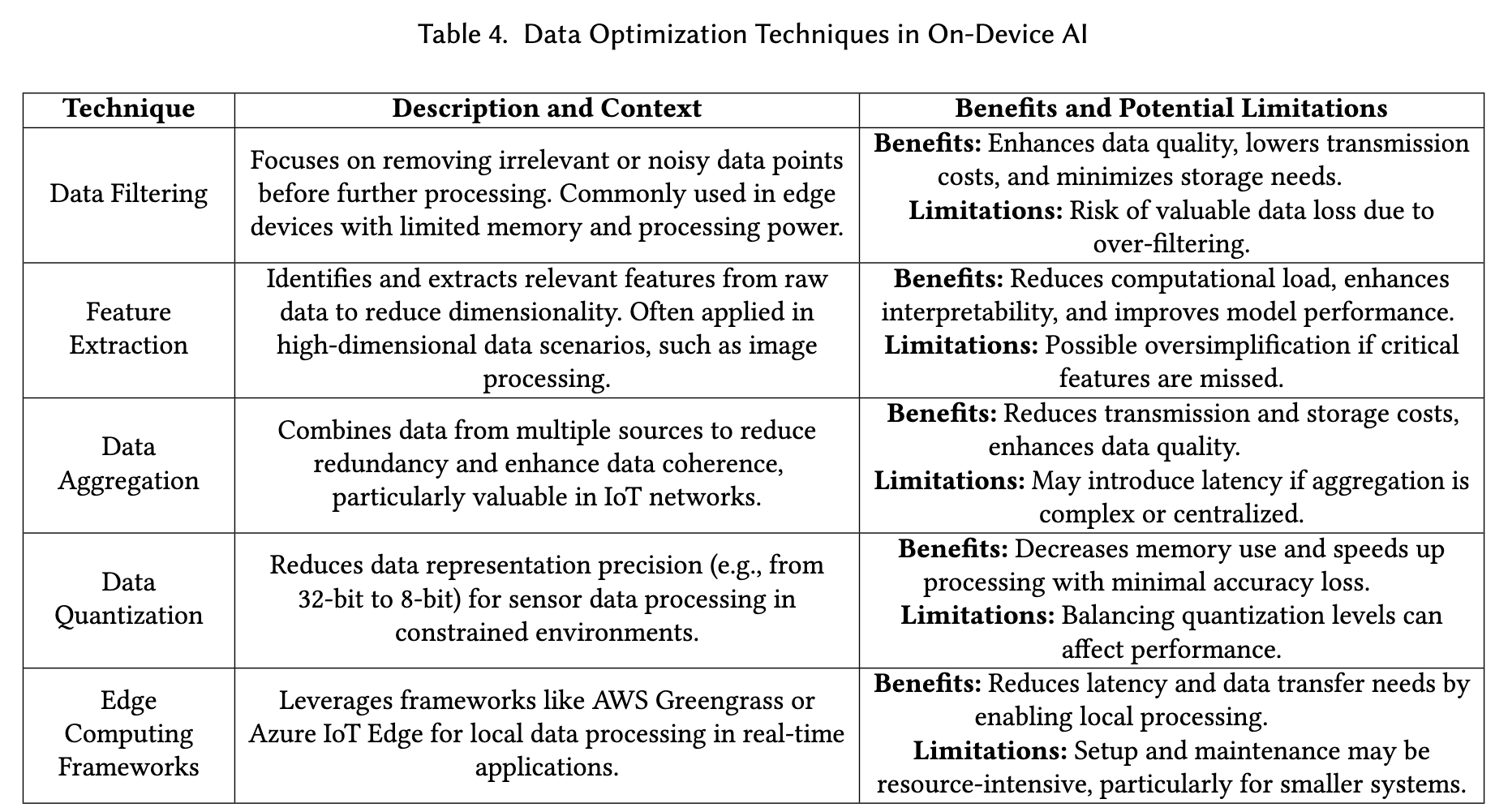

数据优化策略

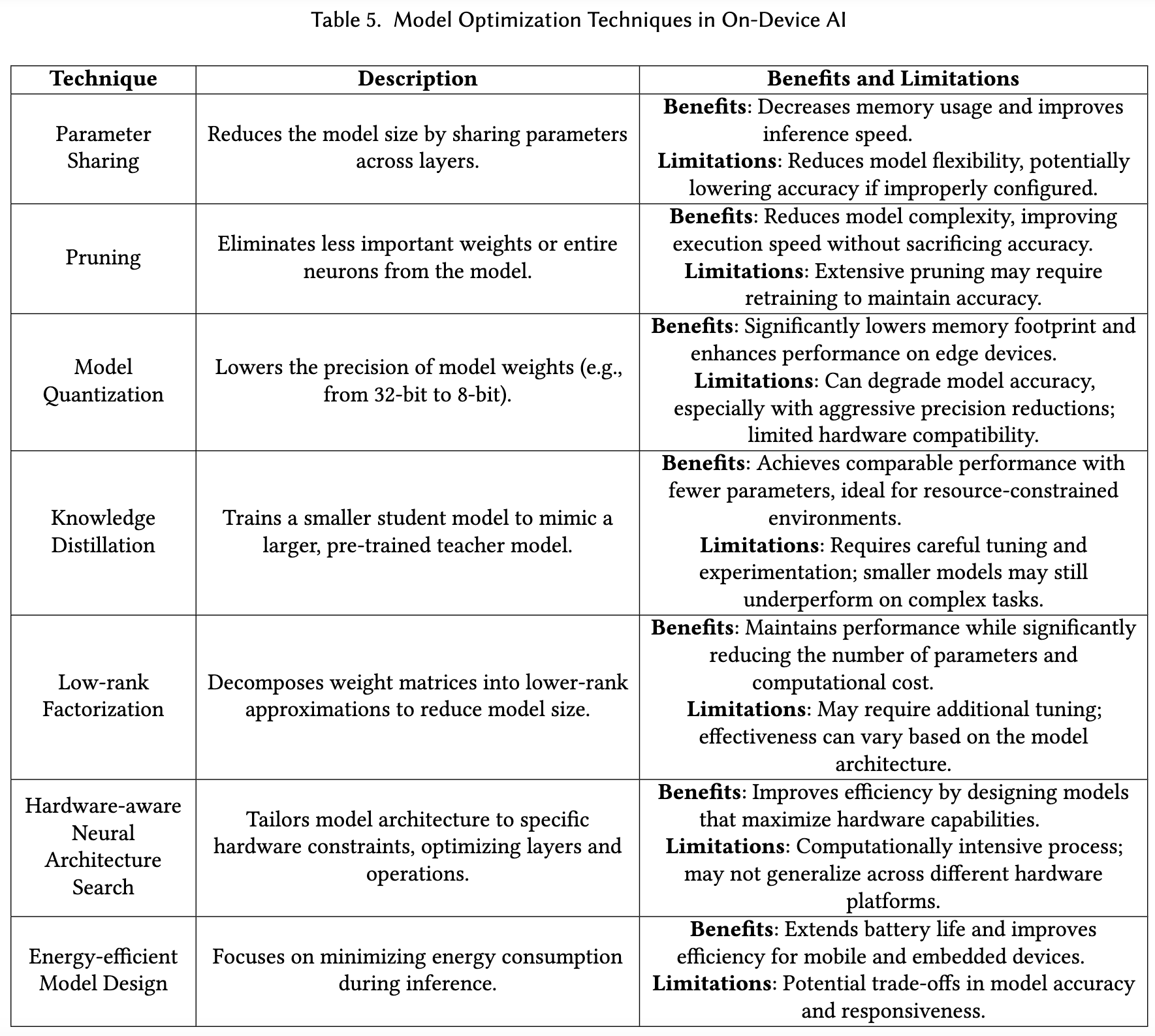

在机器学习领域,“垃圾进,垃圾出”的原则强调了高质量数据输入对实现可靠结果的重要性,尤其是在大型语言模型的开发中,训练数据的规模和质量的提升显著改善了模型性能。为了在边缘设备上有效部署模型,数据预处理显得尤为关键。综述介绍了设备端人工智能中常用的数据优化技术,以确保高效且高质量的数据处理。这些方法包括数据过滤、特征提取、数据聚合和数据量化,每种方法都针对设备端AI模型的特定应用和优势进行了优化。模型优化策略

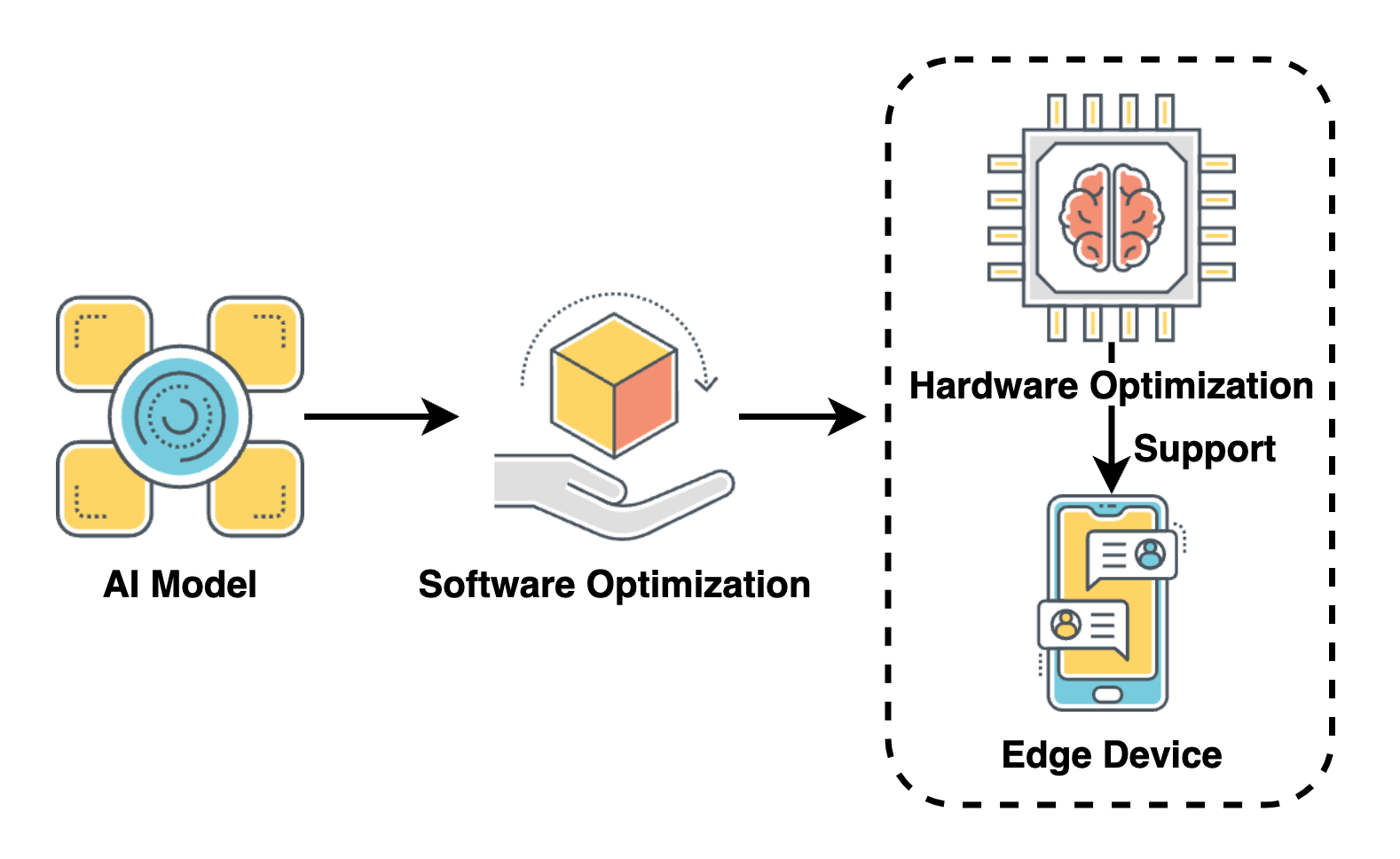

为了在边缘设备上有效部署人工智能模型,开发了一系列模型优化技术,以应对这些设备通常面临的严格计算、内存和功耗限制。这些方法旨在在保持性能水平的同时,减少AI模型的大小和复杂性。模型优化操作的概述包括模型压缩和模型设计,其中模型压缩通过剪枝、模型量化和知识蒸馏等技术减少模型大小,以获得在保持高准确度的同时需要更少资源的紧凑模型。而模型设计则通过手动和自动技术(如架构选择、参数调优和正则化)创建轻量级模型。系统优化策略

随着对实时性能和资源高效的深度学习模型需求的不断增加,针对设备端人工智能部署的系统优化已成为一个关键研究领域。成功在边缘设备上部署深度学习模型需要结合软件和硬件的方法,以提高计算效率。综述提供了轻量级模型训练和推理框架的全面概述,从软件角度出发,同时介绍了旨在加速模型性能的硬件方法。

5. 研究空白与挑战

5.1 识别空白

尽管现有文献对设备端AI的各个方面进行了深入研究,但仍然存在一些研究空白。例如:

- 如何在极度受限的物联网设备上实现复杂AI任务。

- 如何在动态变化的环境中保持设备端AI模型的性能和鲁棒性。

- 如何在保护用户隐私的同时实现高效的联邦学习。

此外,针对特定行业和应用场景的定制化设备端AI模型设计与优化方法也需要更深入的研究。

5.2 面临的挑战

设备端AI模型的研究和应用面临着多方面的挑战:

- 有限的计算资源:边缘设备的计算能力、存储空间和能源供应有限,难以支持计算密集型和参数庞大的AI模型。

- 存储和内存限制:设备存储空间和内存容量的限制对大型模型的部署和运行提出了挑战。

- 能源消耗管理:移动和物联网设备依赖电池供电,AI模型的能耗直接影响设备的续航能力。

- 通信带宽限制:边缘设备与云端之间的通信带宽有限,难以传输大量数据。

- 数据隐私和安全:在设备端处理敏感数据需要采取有效的隐私保护和安全措施,以防止数据泄露和恶意攻击。

- 模型的可迁移性和适应性:AI模型需要在不同类型的设备和不同的环境条件下保持良好的性能。

- 持续学习能力:设备端AI模型需要具备在实际使用中不断学习和适应用户需求的能力。

6. 结论与建议

6.1 总结

本综述全面探讨了设备端AI模型的基本概念、广泛的应用场景、面临的关键技术挑战以及相应的优化和实现方法。研究表明,设备端AI模型在各个领域都展现出巨大的应用潜力,但在计算资源、存储、能源、通信、隐私安全以及模型适应性等方面仍然存在显著的挑战。通过模型压缩、硬件加速、数据优化等技术的进步,设备端AI模型的性能得到了显著提升。

未来,随着新兴技术的进步以及对可持续性和伦理问题的日益关注,设备端AI模型将朝着更智能、更高效、更安全的方向发展。

6.2 未来研究建议

为了进一步推动设备端AI模型的发展和应用,我们提出以下研究建议:

- 持续深入研究高效的模型压缩和剪枝技术:在保持模型精度的前提下,进一步降低计算和存储需求,以适应资源受限的设备环境。

- 加强硬件与软件的协同设计:充分利用新兴硬件技术(如FPGA和TPU)的优势,提升计算效率和能源管理水平,确保AI模型能够在边缘设备上高效运行。

- 开发更强大的数据保护机制和隐私保护算法:确保设备端敏感数据处理的安全性与合规性,防止数据泄露和恶意攻击。

- 重视AI模型的公平性和可解释性研究:避免决策过程中的偏见,增强用户对AI技术的信任,确保AI系统的透明性和可理解性。

- 促进计算机科学、社会科学和伦理学等多学科的交叉合作:全面理解AI技术的社会影响,并制定合理的政策和标准,以确保技术的健康发展。

设备端AI模型的未来发展前景广阔,其在提升生活质量、驱动产业转型和促进可持续发展等方面都将发挥重要作用。未来的研究和实践应着重于技术的可持续性和伦理影响,以确保AI技术健康发展,造福全人类。

参考文献

- [1] Xubin Wang, Zhiqing Tang, Jianxiong Guo, Tianhui Meng, Chenhao Wang, Tian Wang, Weijia Jia, *Empowering Edge Intelligence: A Comprehensive Survey on On-Device AI Models, ACM Computing Surveys, Mar 2025.